Die Idee:

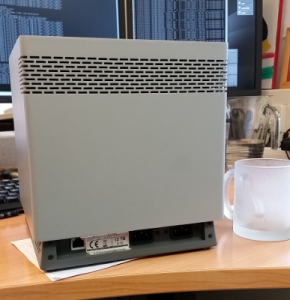

Mein altes NAS (Dlink DNS323) genügte schon lange nicht mehr meinen Anforderungen.

Da auch immer mehr Dienste in meinem Netzwerk dauernd zur Verfügung stehen sollten, war schnell klar,

dass ein neues System sehr modular (wie ein echter PC/Server [SOHO -small office home office – NAS]) aufgebaut sein sollte.

Als mein Arbeitgeber dann auch noch Teile eines WORM-Speichers austauschte (und mir zur Verfügung stellte)

war die Idee geboren, einen Linux Server mit möglichst wenig Stromverbrauch in diesen Würfel zu bauen.

Die Ausganssituation:

Ein Speicherwürfel eines WORM-Speichers einer Langzeitarchivierungslösung. (keine Ahnung ob ich den Namen nennen darf.)

In diesem Speicherwürfel finden 12 Stück 3,5″ Festplatten Platz.

Die Netzteile wurden aus der Basis ausgebaut und die Systemplatine entfernt.

Worm-Speicherwürfel

Die Hardware:

Meinem Kollegen verdanke ich die Realisierung des Projektes.

Ohne ihn hätte ich vermutlich nie ein passendes Mainboard gefunden.

Das

ASRock C2550D4I passt perfekt in den Sockel des Speicherwürfels.

(Test)Platzierung des Mainboardes

Dieses Mainboard hat 12 SATA-Anschlüsse, QuadCore CPU und DDR3 Bänke (hier kann ich auf meinen Fundus zurückgreifen)

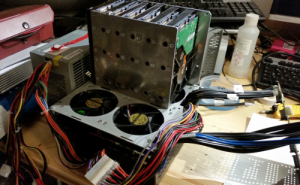

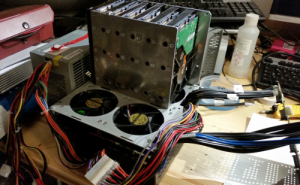

Im Worm-Speicherwürfel erzeugten die Lüfter einen Luftstrom von Unten über die Netzteil-Komponenten, zwischen den Festplatten hindurch

bis der Luftstrom am oberen hinteren Rand das Gehäuse wieder verließ.

Die Festplatten sollen auch weiterhin mit diesem Luftstrom gekühlt werden.

Daher werden die Lüfter einfach etwas weiter oben montiert.

Lüfter

Refurbished Gehäuse

refurbished

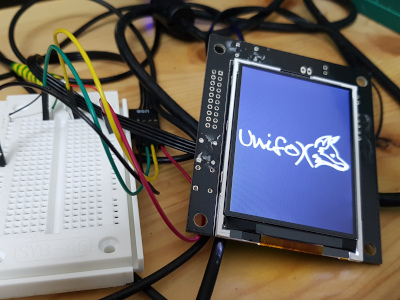

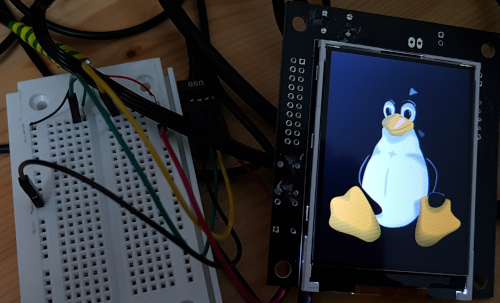

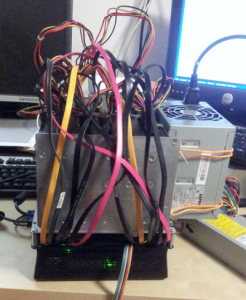

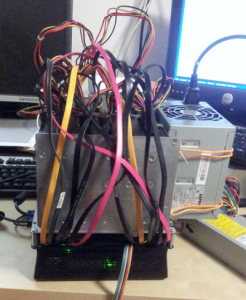

Das Projekt scheint machbar zu sein… Ein Testaufbau soll erste Ergebnisse liefern.

Test-Aufbau

Der Testaufbau scheint vielversprechend, aber bringt auch die Erkenntnis, dass der Einschaltstrom in keinem Verhältnis zur normalen Leistungsaufnahme steht. Um dieses Problem kümmere ich mich später.

So sieht der Standfuß / Sockel des Speicherwürfels mit dem Mainboard aus.

Base-mit-Mainboard

Base-mit-Mainboard

Base-mit-Mainboard

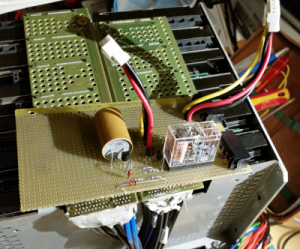

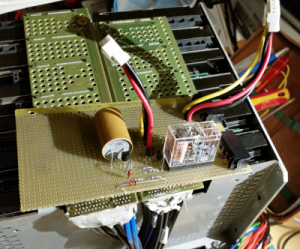

2 LEDs für Power und HDD-Zugriff (für 12 HDDs nur eine LED; mehr gibt das Mainboard nicht her)

und 2 Taster für Power und Reset wurden auf einer Lochplatine angelötet.

LED,Power,Button

Verkabelung:

Aus einem alten ATX-Netzteil und einem alten ATX-Mainboard habe ich mir eine Verlängerung für die Stromversorgung des Mainboards gebastelt.

Die Lötkontakte des ATX-Steckers wurden mit Heißkleber „isoliert“. Silikon kann dafür auch verwendet werden.

Mainboard-Power-Verlängerung

Die 12 SATA- Anschlusskabel wurden sauber verlegt.

SATA-Kabel

SATA-Kabel

Die Enden der SATA Kabel wurden sorgsam an die Platinen gelötet, welche dann auf die Festplattenbläcke gesteckt werden. (Eine sch….öne Arbeit)

Mainboard-mit-SATA-Verbindungen

Die Festplatten wurden zu 2 Festplattenbläcken verschraubt.

Festplatten-Blöcke

Die Festplattenblöcke wurden auf den Sockel montiert (Steckverbindung)

Festplattenblock 1

Festplattenblock 2

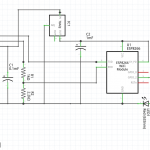

Einschaltstromproblematik:

Der Testaufbau zeigte, dass dieses NAS im „normalen“ Betrieb relativ wenig Leistung verbraucht. (siehe unten)

Die Stromaufnahme von 12 startenden Festplatten ist aber nicht zu unterschätzen.

Meine Tests Zeigten, dass es keine Probleme gibt, wenn 6 Festplatten mit einer Verzögerung von ca.3 Sekunden starten.

Durch eine kleine Platine wird der zweite Festplattenblock erst Zeit verzögert mit Strom versorgt.

Dadurch sinkt der Einschaltstrom so weit ab, dass ich mein altes Netzteil mit 350W max. weiterverwenden kann.

Einschaltverzögerung

In der Zwischenzeit wurde noch ein alter USB-Stick neben dem Mainboard im Sockel eingebaut.

Auf diesem USB-Stick wurde das Betriebssystem installiert. Dadurch ist es möglich alle Festplatten schlafen zu legen.

Das spart nicht nur Energie, sondern senkt auch den Geräuschpegel des Speichers.

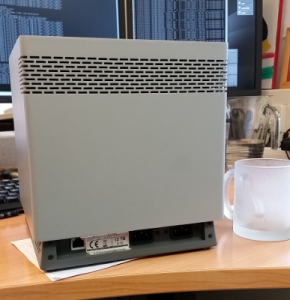

ein neues Gehäuse:

Das Original-Gehäuse ist leider zu wenig hoch.

Hier noch ein letzter Blick auf mein NAS bevor es neu eingekleidet wird.

Gehäuse

Gehäuse

Leistungsdaten:

- Intel Avoton C2550 Quad-Core Processor

- 4GB DD3 RAM (1 von 4 Bänken belegt) max. 64GB RAM

- 2x 1GBit LAN

- 1x Management LAN

- Formfaktor Mini ITX

- 12 x 1TB SATA (Das Mainboard wurde auch schon erfolgreich mit 4TB Festplatten betrieben)

Abmessungen:

25cm x 26cm x 42cm

12x 3,5″ Festplatten auf 27 300cm² oder 0,0273m² oder 27,3l.

12TB auf 27,3l

Leistungsverbrauch: (ab Steckdose)

Ich habe mir nun doch ein neues Netzteil eingebaut. Das alte ist doch schon ca. 10 Jahre alt, und so ein Billigteil.

Die folgenden Werte wurden mit dem neuen Netzteil (Super Flower Golden Green HX Series 350W 80PlusGold) gemessen.

Einschaltzeitpunkt: 180W max.

Alle 4 CPU Kerne aktiv; alle 12 Festplatten eingeschaltet, alle 4 Lüfter 100%: 95W

Wenn sich das NAS langweilt (alle Festplatten spindown, nur eine CPU aktiv) zwischen 50 und 60W.

Gewinnspiel:TK

Die Thomas-Krenn.AG veranstaltete ein Gewinnspiel zum Thema „Kreativ mit Servern“.

Da ich scheinbar der einzige Teilnehmer war, kann ich nun eine neue SSD mein eigen nennen.

Facebook-Post von TK

Diese SSD ersetzt eine der HDDs, und ist für das Betriebssystem zuständig. (Ist doch um einiges schneller als ein USB2.0 – Speicherstick)